Imágenes médicas reconstruidas con IA pueden no ser confiables

Por el equipo editorial de MedImaging en español

Actualizado el 16 Jun 2020

Un estudio nuevo sugiere que las herramientas de aprendizaje profundo utilizadas para crear imágenes de alta calidad a partir de tiempos de escaneo cortos producen múltiples alteraciones y artefactos en los datos que podrían afectar el diagnóstico.Actualizado el 16 Jun 2020

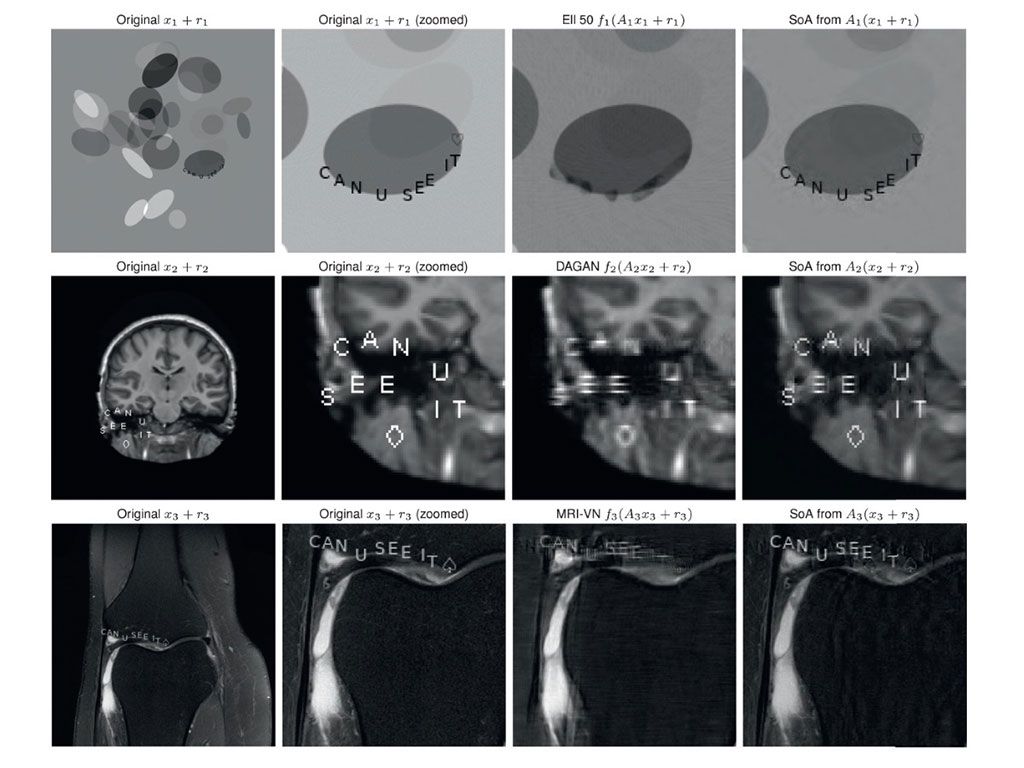

Investigadores de la Universidad de Oslo (Noruega), la Universidad de Cambridge (Reino Unido) y otras instituciones, realizaron un estudio para evaluar seis redes neuronales diferentes de inteligencia artificial (IA) entrenadas para crear imágenes mejoradas a partir de exámenes de resonancia magnética (RM) o de tomografía computarizada (TC). Las redes se alimentaron de datos diseñados para replicar tres posibles problemas: pequeñas perturbaciones; pequeños cambios estructurales; y cambios en la frecuencia de muestreo en comparación con los datos sobre los que se entrenó la IA. Para probar la capacidad de los sistemas de detectar pequeños cambios estructurales, el equipo agregó letras y símbolos de cartas de juego a las imágenes.

Imagen: Imágenes con pequeñas perturbaciones estructurales (texto y símbolos) reconstruidas con IA (Fotografía cortesía de PNAS)

Los resultados mostraron que solo una de las redes pudo reconstruir estos detalles, pero las otras cinco presentaron problemas que iban desde la borrosidad hasta la eliminación casi completa de los cambios. Solo una de las redes neuronales produjo mejores imágenes a medida que los investigadores aumentaron la frecuencia de muestreo de los escaneos. Otra red se estancó, sin mejoras en la calidad; y en tres, las reconstrucciones disminuyeron en calidad a medida que aumentó el número de muestras. El sexto sistema de IA no permitió cambiar la frecuencia de muestreo. El estudio fue publicado el 11 de mayo de 2020, en la revista Proceedings of the National Academy of Sciences (PNAS).

“Te molestas un poco y el sistema de IA dice que la imagen del gato es de repente un camión de bomberos. Los investigadores deben comenzar a probar la estabilidad de estos sistemas. Lo que verán a gran escala es que muchos de estos sistemas de IA son inestables”, dijo el autor principal, Anders Hansen, PhD, de la Universidad de Cambridge. “El gran problema es que no existe una comprensión matemática de cómo funcionan estos sistemas de IA. Se convierten en una caja negra, y si no se prueban estas cosas correctamente, puede tener resultados completamente desastrosos”.

Las inestabilidades durante el escaneo pueden aparecer como ciertas perturbaciones pequeñas, casi indetectables (por ejemplo, debido al movimiento del paciente, que aparecen tanto en la imagen como en el dominio de muestreo, lo que resulta en artefactos en la reconstrucción; como pequeños cambios estructurales, por ejemplo, un tumor, que puede no ser capturado en la imagen reconstruida y diferentes tasas de muestreo que no coinciden con los datos con los que se entrenó el algoritmo de IA.

Enlace relacionado:

Universidad de Oslo

Universidad de Cambridge