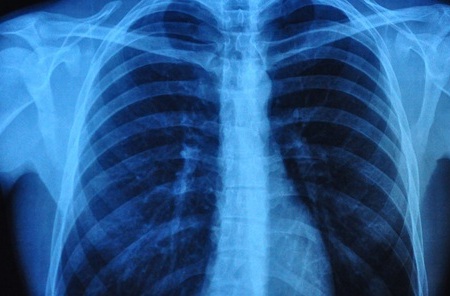

Herramienta de diagnóstico de IA funciona a la par que radiólogos en detección de enfermedades en radiografías de tórax

Actualizado el 22 Sep 2022

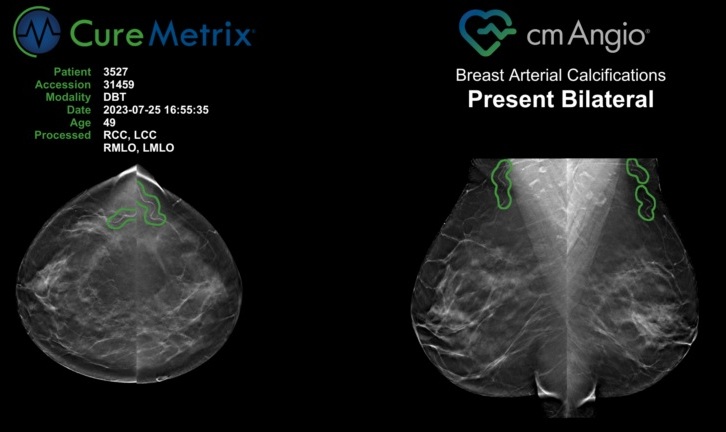

La mayoría de los modelos de inteligencia artificial (IA) requieren el etiquetado de conjuntos de datos durante su "entrenamiento" para que puedan aprender a identificar correctamente las patologías. Este proceso es especialmente engorroso para las tareas de interpretación de imágenes médicas, ya que implica la anotación a gran escala por parte de médicos humanos, lo que a menudo es costoso y requiere mucho tiempo. Por ejemplo, para etiquetar un conjunto de datos de rayos X de tórax, los radiólogos expertos tendrían que mirar cientos de miles de imágenes de rayos X una por una y anotar explícitamente cada una con las condiciones detectadas. Si bien los modelos de IA más recientes han tratado de abordar este cuello de botella de etiquetado aprendiendo de datos no etiquetados en una etapa de "entrenamiento previo", eventualmente requieren un ajuste fino en los datos etiquetados para lograr un alto rendimiento. Ahora, los científicos han desarrollado una herramienta de diagnóstico de IA que puede detectar enfermedades en radiografías de tórax, directamente a partir de descripciones del lenguaje natural contenidas en los informes clínicos que las acompañan.

El nuevo modelo llamado CheXzero que fue desarrollado por científicos de la Facultad de Medicina de Harvard (Boston, MA, EUA) y colegas de la Universidad de Stanford (Stanford, CA, EUA) es autosupervisado, en el sentido de que aprende de manera más independiente, sin necesidad de datos etiquetados a mano antes o después del entrenamiento. El paso se considera un avance importante en el diseño de IA clínica porque la mayoría de los modelos de IA actuales requieren una laboriosa anotación humana de grandes cantidades de datos antes de que los datos etiquetados alimenten el modelo para entrenarlo. El modelo se basa únicamente en radiografías de tórax y las notas en inglés que se encuentran en los informes de rayos X adjuntos. El modelo fue “entrenado” en un conjunto de datos disponible públicamente que contiene más de 377.000 radiografías de tórax y más de 227.000 notas clínicas correspondientes.

Luego, se probó su desempeño en dos conjuntos de datos separados de radiografías de tórax y las notas correspondientes recopiladas de dos instituciones diferentes, una de las cuales estaba en un país diferente. Esta diversidad de conjuntos de datos tenía como objetivo garantizar que el modelo funcionara igual de bien cuando se expusiera a notas clínicas que pueden usar una terminología diferente para describir el mismo hallazgo. Tras las pruebas, los investigadores identificaron con éxito patologías que no fueron anotadas explícitamente por médicos humanos. Superó a otras herramientas de IA autosupervisadas y funcionó con una precisión similar a la de los radiólogos humanos. El enfoque, dijeron los investigadores, eventualmente podría aplicarse a modalidades de imágenes mucho más allá de los rayos X, incluidas las tomografías computarizadas, las resonancias magnéticas y los ecocardiogramas.

“Estamos viviendo los primeros días de los modelos médicos de inteligencia artificial de próxima generación que pueden realizar tareas flexibles aprendiendo directamente del texto”, dijo el investigador principal del estudio, Pranav Rajpurkar, profesor asistente de informática biomédica en el Instituto Blavatnik en HMS. “Hasta ahora, la mayoría de los modelos de IA se han basado en la anotación manual de grandes cantidades de datos, alrededor de 100.000 imágenes, para lograr un alto rendimiento. Nuestro método no necesita tales anotaciones específicas de la enfermedad”.

“Con CheXzero, uno puede simplemente alimentar al modelo con una radiografía de tórax y el informe de radiología correspondiente, y aprenderá que la imagen y el texto en el informe deben considerarse similares; en otras palabras, aprenderá a coincidir la radiografía de tórax con su informe adjunto”, agregó Rajpurkar. “El modelo puede eventualmente aprender cómo los conceptos en el texto no estructurado se corresponden con los patrones visuales en la imagen”.

Enlaces relacionados:

Facultad de Medicina de Harvard

Universidad de Stanford